Tecnología

Pronto su iPhone le alertará si está sosteniendo el teléfono demasiado cerca de su cara

Apple prepara varias novedades que llegarían con la actualización de iOS 17

Actualmente muchos usuarios de teléfonos inteligentes han desarrollado una gran dependencia por su teléfono inteligente, por ese motivo tienen dificultades para poder desprenderse del smartphone. Pero esta situación tiene una incidencia negativa en la salud visual de las personas, puesto que la exposición prolongada a la luz de la pantalla puede elevar el riesgo de padecer miopía.

Aunque algunos fabricantes de teléfonos han implementado varias funcionalidades, como el ‘modo lectura’ o ‘protector de vista’, para atenuar el brillo y la presencia de luz azul en la pantalla del dispositivo, estas opciones parecen ser insuficientes ante los usuarios que no pueden mantener el teléfono a una sana distancia de sus ojos.

No obstante, un informe publicado en el Dailymail señala que Apple ya estaría preparando una novedad que le podría poner fin a ese problema.

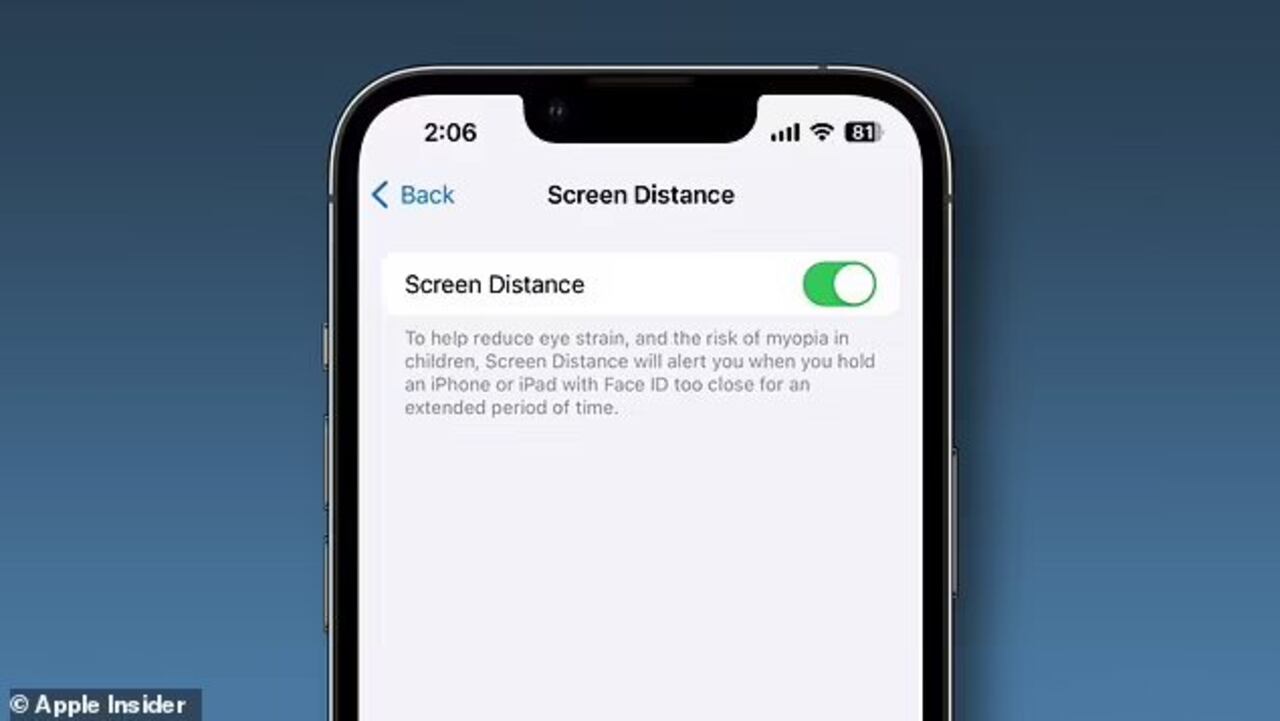

Se trata de una herramienta llamada Distancia de pantalla, la cual estaría disponible con la próxima actualización de iOS 17 para iPhone. Esta opción tendría la facultad de monitorear la posición del iPhone en función del rostro del usuario, para así generar alertas en caso de que el teléfono esté muy cerca a la cara.

Lo más leído

Cabe precisar que esta función fue anunciada en el marco del evento WWDC 2023 de Apple en Cupertino, California, allí se comentó que el ayudar a mantener una sana distancia entre el dispositivo y el rostro puede ayudar a reducir el riesgo de padecer miopía, además, de disminuir la visual digital en el usuario.

De acuerdo con el medio en mención, esta nueva característica se apoyará en la cámara ‘TrueDepth’, la cual opera proyectando una gran cantidad de puntos invisibles en el rostro para así generar un mapa de digital de la cara del usuario.

Así las cosas, con la llegada del sistema “Screen Distance in Screen Time” el iPhone le ayudará a su usuario a adoptar el hábito de sostener su teléfono a una distancia de al menos 12 centímetros de su rostro.

Vale la pena reiterar que esta funcionalidad estará disponible con el lanzamiento de la actualización de iOS 17, que se lanzará en septiembre.

Apple trabaja en sistema que detecta los movimientos de la boca y lee los labios del usuario

Apple ha ideado un sistema para detectar los movimientos de la boca y leer los labios del usuario durante los comandos de voz en entornos con interferencias y que se aplicaría a dispositivos que soporten el asistente digital de la compañía.

La firme dispone de un asistente inteligente, Siri, que registra peticiones como la de escribir y enviar un mensaje, fijar recordatorios o llevar a cabo acciones como llamar a un contacto o compartir la llegada a un lugar con otro usuario.

Sin embargo, tal y como recuerda Apple Insider, este encuentra ciertas dificultades para entender las peticiones de los usuarios en diferentes escenarios, por ejemplo, cuando hay ruido en el lugar desde el que se está utilizando. Las distorsiones son también otro de los problemas a los que se enfrenta Siri.

La compañía tecnológica ha ideado un sistema de reconocimiento de voz que detecta diferentes datos de movimiento, generado por las vibraciones durante el habla, que recoge en una patente firmada por los desarrolladores Eddy Zexing Liang y Madhu Chinthakunta, que Apple presentó en enero en Estados Unidos y que se ha publicado este jueves.

“Cuando un usuario habla, la boca, la cara, la cabeza y el cuello se mueven y vibran. Los sensores de movimiento, como acelerómetros o giroscopios, pueden detectar estos movimientos y consumen relativamente poca energía, en comparación con los sensores de audio, como los micrófonos”, se puede leer en este documento.

Este sistema de reconocimiento sería capaz de comparar con movimientos de la boca anteriormente aprendidos y contrastar si lo que solicita el usuario coincide con palabras o frases de comandos de voz previos para encontrar coincidencias. Es decir, leería los labios del usurios para entender su petición.

Gracias a este sistema, los dispositivos en los que estuviese implementado este sistema de reconocimiento de voz serían capaces de reconocer comandos como ‘Oye, Siri’ y otras órdenes simples o habituales, como ‘siguiente canción’. Estas acciones se reflejarían en el iPhone después de vincularlo a los equipos electrónicos.

Para cumplir con sus objetivos, Apple debería analizar un gran conjunto de datos sobre los movimientos que los usuarios realizan para pronunciar cada palabra y crear perfiles de voz, para que el sistema pueda diferenciar tanto la pronunciación de cada usuario como el idioma en que se realizan estas peticiones.